在进行大规模数据采集时,如何合理安排和管理爬取任务的时间成为了每个专业程序员需要面对的挑战。本文将分享一些关于批量采集中时间管理和优化方面的实用技巧,帮助你提升爬虫工作效率。

1. 制定明确目标并设置合适频率

首先要明确自己所需获取数据的范围,并根据具体情况设定合理且可行性强 的访问频率。避免过快或过慢地发起请求以及不必要地浪费资源。

例如,在设计一个新闻网站内容抓取系统时,可以通过分析历史数据来确定最佳更新间隔,并结合热度指数等因素调整刷新策略。

示例代码:

```python

import time

def crawl_news():

while True:

# 爬取新闻页面信息

# 处理解析得到的数据

time.sleep(60) # 设置每分钟执行一次

crawl_news()

```

2. 并行处理多个任务

通过使用异步编程、多线程或分布式等方法,在保证稳定性前提下同时处理多个网站或页面信息收集任务,从而缩短整体耗时并增加吞吐能力。

比如利用Python中`asyncio`库进行异步操作, 或者使用Scrapy框架内置支持的并发机制来加速网络请求响应与解析流程。

示例代码:

```python

import asyncio

# 使用asyncio实现异步爬虫任务

async def crawl_website(url):

# 发起HTTP请求

# 处理页面数据

tasks = [crawl_website(url1), crawl_website(url2), ...]

loop = asyncio.get_event_loop()

results = loop.run_until_complete(asyncio.gather(*tasks))

```

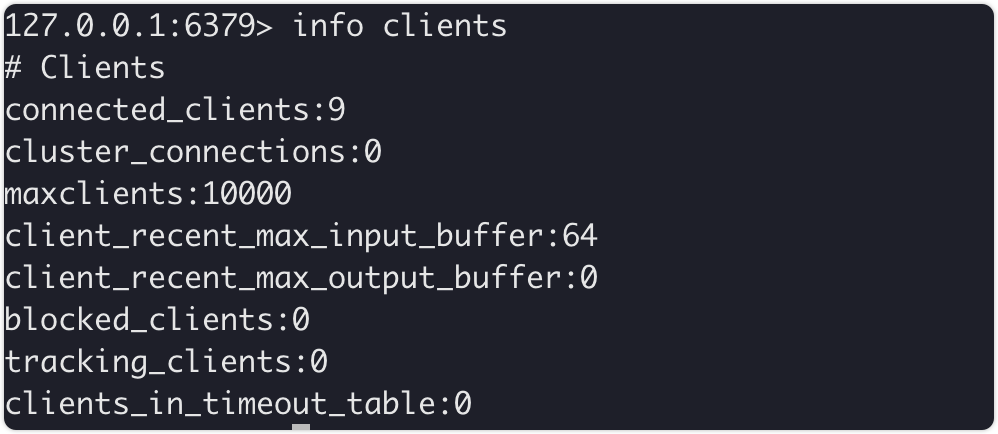

3. 合理利用缓存机制

针对经常变动较小但是重复出现内容(例如公告类网页),可以考虑使用缓存来减少网络传输开销以及降低服务器压力。这样可以节省宝贵时间和系统资源,提高运行速度。

一种简单的方法就是将已爬取数据保存到本地数据库或者文件中,并在下次请求时先检查是否存在,避免无谓的网络访问。

示例代码:

```python

import requests

def get_cached_data(key):

cache_data = load_from_cache() # 从缓存加载数据

if key in cache_data:

return cache_data[key]

data = fetch_new_data(key) # 获取新数据

// 更新缓存

save_to_cache(data)

return data

data_1= get_cached_date('key_1')

data_2= get_cached_date('key_2')

```

4. 错误恢复与断点续传功能

在进行大规模的批量爬虫采集时,难免会遇到各种网络异常或错误。为了提高稳定性和可靠性,在代码中添加适当的错误处理机制,并实现断点续传功能以便于恢复任务。

通过记录每个页面抓取状态、失败日志等信息,能够快速发现问题并修正;同时设置合理间隔重新尝试连接失败链接也有助于增加成功率。

示例代码:

```python

import requests

def crawl_page(url):

try:

response = requests.get(url)

# 处理响应数据

except Exception as e:

log_error(e) # 记录异常日志

crawl_page('https://example.com')

```

5. 合理利用分布式技术

对于需要同时访问多个网站或者具有较长响应时间的请求, 可以考虑使用分布式架构来加速数据获取过程。通过将工作负载合理地分配给多台服务器并行执行,可以显著减少单一节点压力及运行耗时。

Hadoop、Spark等分布式计算框架可以帮助实现任务的并行化与负载均衡,提高整体效率。

示例代码:

(这里展示一个基本思路)

```python

from multiprocessing import Pool

# 使用进程池实现分布式爬虫任务

def crawl_website(url):

# 发起HTTP请求

# 处理页面数据

if __name__ == '__main__':

urls = [url1, url2, ...]

pool = Pool(processes=4) # 创建进程池,设置并发数为4

results = pool.map(crawl_website, urls)

```

以上是关于如何管理和优化批量爬取任务时间方面的一些建议与技巧。希望这些经验能够帮助你更好地完成高效、快速且稳定 的数据采集工作。请根据自身需求选择适宜方法,并不断探索新思路进一步提升效率。